Le numérique au secours de la reconstruction de Notre-Dame de Paris ? L’incendie qui a ravagé la cathédrale Notre-Dame le 15 Avril 2019 a été un choc et un drame. Ceci pour tous les chrétiens, et, globalement pour le monde entier, quelles que soient les croyances et opinions.

Notre époque et le numérique peuvent aider à la reconstruction de Notre-Dame plus rapidement. Olivier Pavie pose un regard optimiste sur la situation. Il montre que le monde du numérique et des nouvelles technologies contribuera à accélérer la renaissance de ce symbole universel.

Reconstruction de Notre-Dame , en quoi le numérique peut-il aider?

Le sujet est vaste. Je ne vais pas rentrer dans les détails ni dans les choix qui s’offrent pour la reconstruction de Notre-Dame. Que ce soit avec d’autres matériaux, avec ou sans un concours d’architecte, etc. Pour commencer, comme il n’est pas possible de construire ou reconstruire sans des plans précis, on peut déjà parler des plans de la cathédrale telle qu’elle était. On peut garantir que jamais dans les 856 ans d’existence de ce monument commencé en 1163, achevé près de deux siècles plus tard, on n’a eu autant d’informations la concernant. Notre-Dame de Paris est aujourd’hui un des lieux les plus documentés. A commencer par les photographies numériques prises par les 13 millions de touristes qui viennent la visiter chaque année. Mais ce n’est pas tout, loin s’en faut.

Des scanners laser 3D utilisés pour Notre-Dame de Paris ?

Les travaux engagés récemment pour son entretien et sa sauvegarde ont nécessité d’être réalisés sur la base de relevés géométriques et structurels utilisant les dernières technologies. On parle ici de méthode classique de relevé mais aussi de scanner laser 3D. Il y a parfois des initiatives et concours de circonstances qui peuvent amener leur pierre à l’édifice si je peux dire. En 2010, Andrew Tallon, historien de l’art spécialiste de la représentation et de l’analyse architecturales par scanographie laser et dans l’architecture gothique avait entrepris la numérisation au laser 3D de l’intérieur et de l’extérieur de Notre Dame.

Un heureux hasard ?

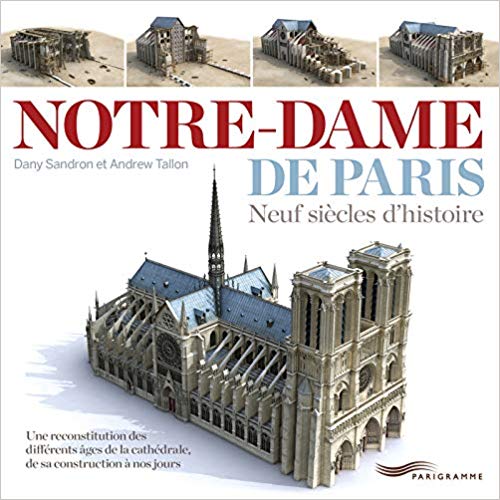

Ce n’était pas vraiment un hasard. Cet historien malheureusement décédé en novembre 2018 à l’âge de 49 ans s’était résolument spécialisé dans l’art gothique français et sur les cathédrales. Il a numérisé plusieurs d’entre elles en France mais aussi à l’étranger, notamment la cathédrale de Canterbury en Angleterre. Il a publié un ouvrage sur Notre Dame de Paris en 2013 co-écrit avec un autre historien, Dany Sandron. En voici d’ailleurs le sujet : « à travers de saisissantes images de synthèse, réalisées grâce à un relevé au laser en trois dimensions, cet ouvrage retrace visuellement les moments-clés de la construction de la cathédrale, puis les remaniements dont elle a été l’objet, jusqu’à la grande restauration de Viollet-le-Duc et Lassus au XIXe siècle. »

Un ouvrage intéressant sur la construction de Notre-Dame au cours des siècles

Cet ouvrage marquait le 850 ème anniversaire de la cathédrale. La précision de la numérisation qu’avait entrepris Andrew Tallon est de 5 mm. La cathédrale ainsi digitalisée a permis de collecter plus d’un milliard de points de référence pour toute la structure. Mais ce n’est pas tout pour ce qui concerne la numérisation. L’éditeur français de jeux vidéo Ubisoft avait entièrement digitalisé la cathédrale en 2014 pour la rendre la plus réaliste possible dans un de ses jeux.

Des éléments suffisants ?

Plus il y a d’informations, mieux c’est. Il y a de nombreux plans de la cathédrale qui ont été faits par morceaux pendant des années. Ce que l’on sait c’est que l’intégralité du relevé de la charpente a été entrepris en 2014 par Rémi Froment et Cédric Trentesaux, deux architectes, et que cela leur a pris deux ans. Quelle que soit la méthode de reconstruction envisagée, y compris à penser à refaire une charpente, par exemple en titane, comme l’a évoqué le célèbre architecte Jean-Michel Wilmotte en indiquant que c’est un matériau moderne, léger et extrêmement solide, on sait exactement et très précisément où se situent les appuis et points d’ancrage de toute la structure, en espérant toutefois qu’un minimum de pierres aient souffert de la chaleur des flammes car le calcaire dont sont faites les pierres a pour inconvénient de ne pas supporter des température trop élevées.

Optimisme pour Notre Dame de Paris

Tout montre que l’on peut être optimiste pour Notre Dame. Nous avons la volonté, nous avons les plans, nous avons le choix dans les projets et matériaux, nous avons les talents et le monde entier participe au financement d’une manière que l’on n’a jamais vue sur terre.

Chronique audio diffusée sur RCF le 23 avril 2019

Sources :

https://www.lemoniteur.fr/article/notre-dame-de-paris-devoile-son-ossature.590209

https://www.youtube.com/watch?v=VAMGRBGU9Js

https://www.amazon.fr/Notre-Dame-Paris-Dany-Sandron/dp/2840967685

Un OS Souverain en France ? Une aberration politique, économique et technologique

Un OS Souverain en France ? Une aberration politique, économique et technologique Des objets connectés, oui mais pas pour n’importe quoi…

Des objets connectés, oui mais pas pour n’importe quoi…

Cette semaine, Olivier Pavie, consultant et écrivain/journaliste dans les nouvelles technologies alerte sur les dangers d’une mauvaise stratégie de mots de passe (écoutez le podcast à la fin de cet article).

Cette semaine, Olivier Pavie, consultant et écrivain/journaliste dans les nouvelles technologies alerte sur les dangers d’une mauvaise stratégie de mots de passe (écoutez le podcast à la fin de cet article).